,

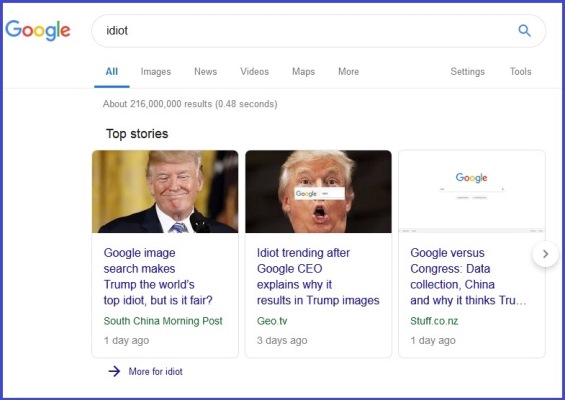

«Мы создаем наши медиа, а затем наши медиа создают нас», говаривал Маршалл Маклюэн. Во время сенатских слушаний об ответственности интернет-компаний за политическую атмосферу в сети, конгрессвумэн Зои Лофгрин спросила директора Google Сандара Пичаи, почему на ее запрос по слову «идиот» Google преимущественно выдает фотографии Трампа. Не то чтобы конгрессвумэн сильно переживала за Трампа — она демократка. Ее интересовал вопрос о том, насколько инженеры поисковика могут вмешиваться в процесс и предопределять параметры поисковой выдачи.

Слушания были посвящены защите частных данных и манипуляциям в интернете. Парламентарии интересовались, может ли кто-то в Google манипулировать результатами выдачи, настраивая алгоритм соответствующим образом.

Свойство поисковика подстраивать поиск под интересы ищущего известно давно и описывается термином Filter Bubble («пузырь предпочтений»). Термин ввел в обиход Илай Паризер в одноименной книге в 2011 году. Суть заключается в том, что алгоритмы выдачи Google, Facebook и других платформ изучают наши лайки, переходы, комментарии, посещаемые страницы, связи с другими людьми, местонахождение, даже, есть такие подозрения, письма, переписку в мессенджерах и услышанные через смартфон реплики, чтобы выдавать наиболее релевантные нашим предпочтениям рекламные сообщения и новости.

Этот отбор предпочтений очень удобен — алгоритм отсекает хлам интернета и выдает тщательно подобранную информацию. Но Filter Bubble также означает, что мы под колпаком. Кроме того, как отмечал Илай Паризер, снижается роль serendipity, то есть случайных открытий, в нашей жизни. Мы оказываемся в отфильтрованном пузыре, в тюрьме собственных вчерашних предпочтений, из которой вырваться почти невозможно.

Этот феномен Илай Паризер иллюстрировал простым примером. Он попросил двух друзей в разных штатах набрать слово «Египет» в поисковике. Одному другу Google выдал информацию о курортах, другому — о революционных событиях Арабской весны. Потому что интересы у друзей были разные. И Google знал это.

Таким образом, алгоритмы интернет-платформ создали совершенно другой механизм формирования повестки дня. Традиционный редактор СМИ, опираясь на свое видение мира, образование, задачи издания, ориентировался на свое понимание интересов аудитории. В ходе развития блогосферы появился новый вид редактуры — вирусный редактор, коллективный фильтр, который отбирал темы в ходе вирусного распространения информации самими людьми в блогах. Наконец, редактор СМИ и вирусный редактор, оба все-таки представлявшие человеческий отбор, оказались заменены алгоритмами релевантности, которые сами изучают предпочтения человека и его собеседников, чтобы формировать картину мира. Алгоритмы, конечно, опираются на огромные массивы статистики, контекстных упоминаний. Но и на предпочтения того, кто ищет. Так Трамп оказался идиотом для конкретной конгрессвумэн.

,

,

Отвечая на вопрос Зои Лофгрин, Сандар Пичаи заявил, что выдача поисковика определяется по 200 параметрам. Ни один человек не может на нее повлиять. И действительно, тот же Илай Паризер отмечал после бесед с инженерами Google, что даже они не в состоянии объяснить, какие ответы и почему алгоритм предлагает на определенные запросы. Сложность работы этого механизма уже превысила человеческое понимание причинно-следственных связей.

Ясно только, что алгоритм учится у людей. Известна другая история с искусственным интеллектом, выпущенным в Twitter компаний Microsoft в 2016 году. Чатбот по имени Tay был призван привлечь к общению миллениалов. За сутки он превратился в расиста, стал сторонником Трампа и даже нацистов, подтвердив тем самым закон Годвина о том, что любой спор в интернете приводит к Гитлеру.

Эффект, видимо, связан с тем, что яркие события в сети привлекают троллей, и они быстро начинают доминировать над умеренными участниками, которые покидают дискуссию из соображений психогигиены, оставляя поле отморозкам.

В то же время, заявлять о том, что алгоритм — это чистая стихия, тоже не стоит. Тот же Твиттер недавно экспериментировал с новым фильтром, который понижал выдачу сообщений тех аккаунтов, у которых в подписчиках люди с радикальными высказываниями. Так соцсеть хотела очистить общение от экстремизма. Небольшая настройка фильтра повлияла на 600 тысяч аккаунтов, включая аккаунты некоторых конгрессменов-республиканцев в США. Они оказались ответственными за то, что кто-то из их подписчиков использовал нехорошие, неполиткорректные фразы.

Twitter потом признал несправедливость настройки и откатил фильтр назад. Но этот случай показывает, что небольшие настройки алгоритма могут кардинально менять картину мира для сотен тысяч или миллионов людей. И если раньше умами граждан владели СМИ, то теперь это делают алгоритмы, причем в масштабах для СМИ немыслимых.

Возвращаясь к фотографиям Трампа, выдаваемых по запросу idiot, можно сказать, что ситуация теперь еще более усугубилась, на этот раз уже не без помощи СМИ. После того, как газеты написали о слушаниях и вопросе Зои Лофгрин главе Google, пользователи бросились проверять выдачу на слово idiot. За два дня поступило более миллиона запросов. Алгоритм намек понял и теперь устойчиво показывает Дональда Трампа. Можете проверить.

Что касается российских реалий, то подобные истории, вероятно, могут только подтолкнуть российские власти к созданию суверенного интернета с контролируемой инфраструктурой. Такие инициативы как раз были недавно в очередной раз выдвинуты депутатами Госдумы.

,